Künstliche Intelligenz hat große Fortschritte gemacht, aber die Qualität der Ergebnisse hängt immer noch davon ab, wie man mit ihr spricht. Genau hier setzt Prompt Engineering an. Es ist die Methode, wie wir unsere Anfragen an KI-Modelle gestalten, strukturieren und optimieren, um vorhersehbare, saubere und wiederverwendbare Ergebnisse zu erzielen.

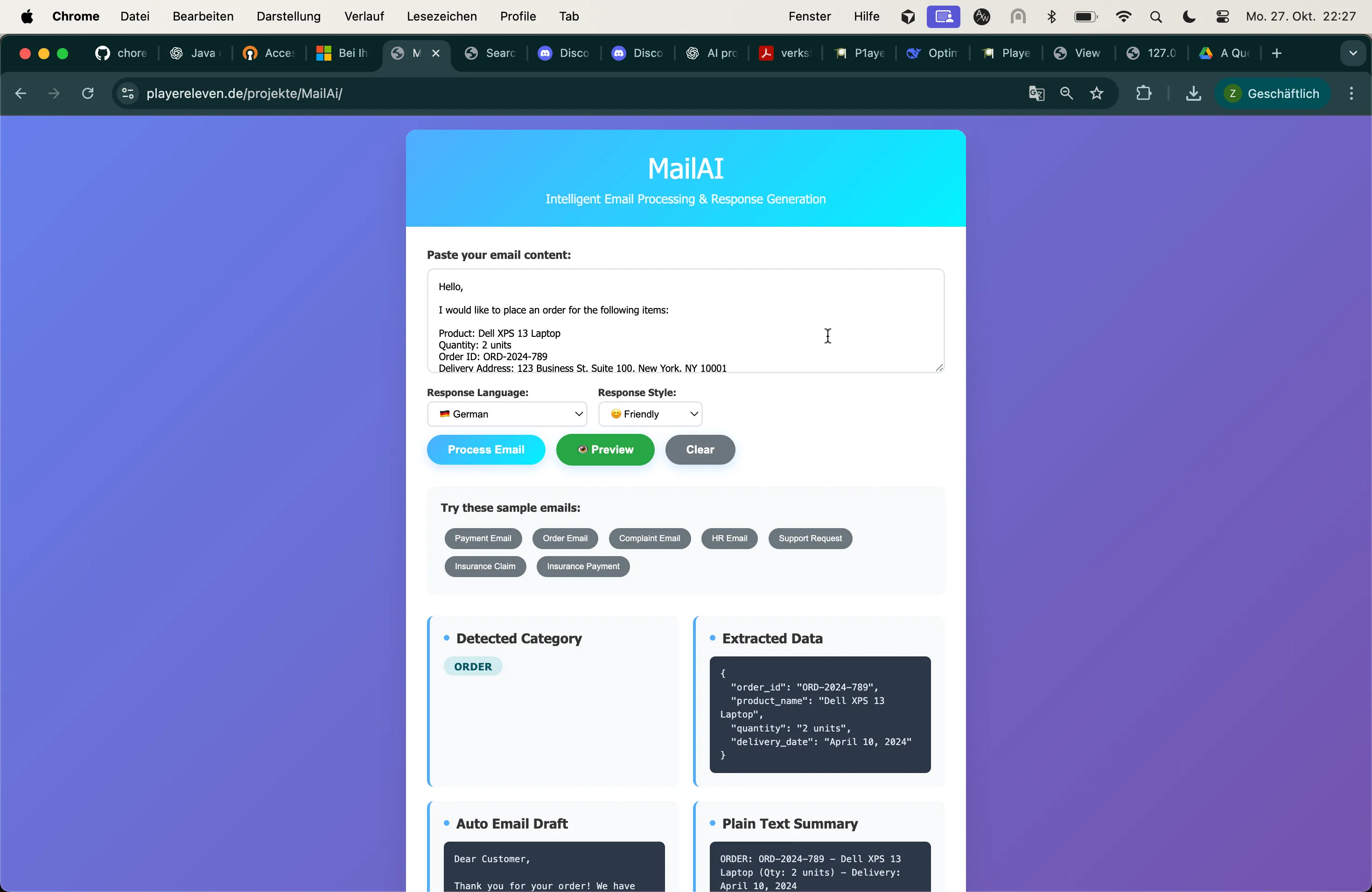

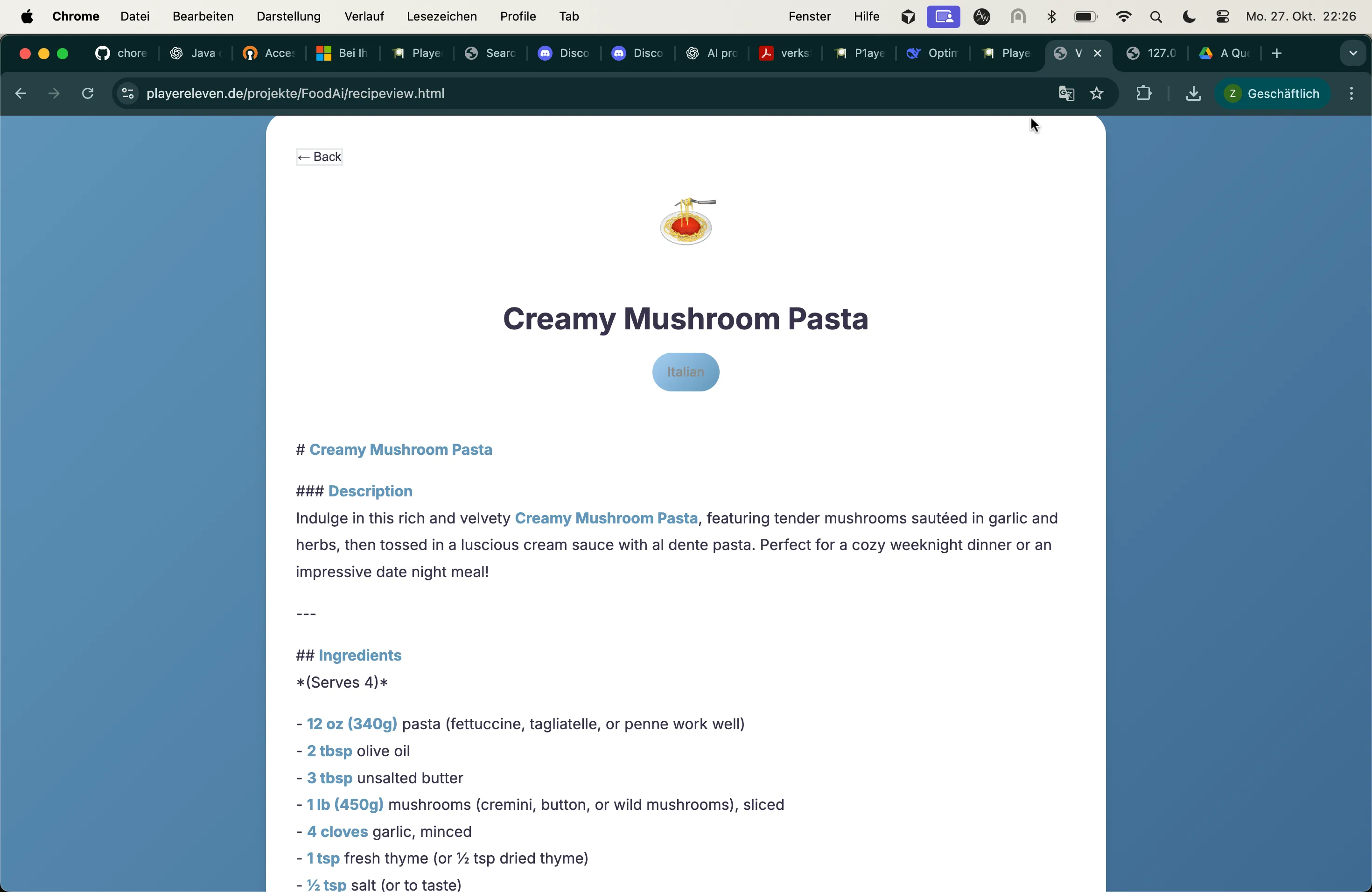

Im Kern geht es beim Prompt Engineering darum, Muster zu definieren: wie die KI Kontext versteht, Schlussfolgerungen anstellt und ihre Antworten formatiert. Richtig umgesetzt, verwandelt es generische Modelle in hocheffiziente Assistenten, fähig zum logischen Denken, Klassifizieren und Erstellen konsistenter Ergebnisse für verschiedene Aufgaben.